近日,电子电气工程学院“融合计算和位置服务”科研团队的骨干老师朱海博士指导2022届硕士研究生吕鸿祥在地球科学和遥感领域顶级期刊《IEEE Transactions on Geoscience and Remote Sensing(IF=8.2,中科院一区TOP期刊)》发表了题为“Direction-Guided Multi-Scale Feature Fusion Network for Geo-localization”的学术论文。IEEE TGRS是地球科学和遥感领域的顶级期刊之一,是IEEE地球科学与遥感技术协会(GRSS)会刊,在遥感技术和地球科学领域具有较高影响力。bat365在线平台为该论文第一署名单位和通讯单位。

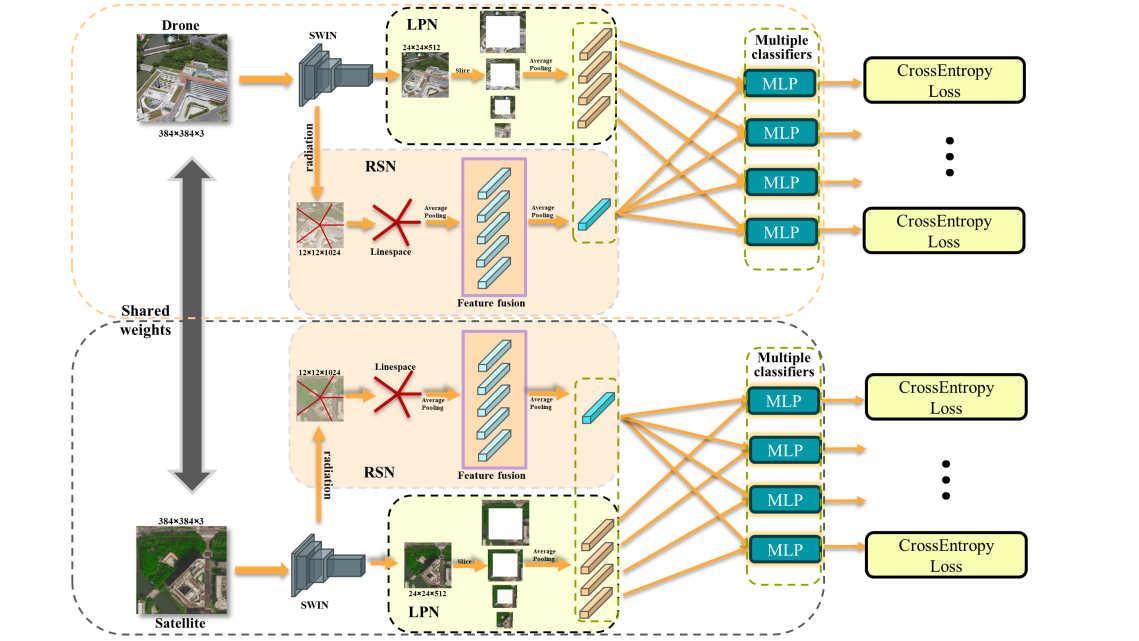

图1 新型的win-Radial-Locality Network跨视图地理定位网络

该研究成果突破了跨视角地理定位技术中方向性特征难以获取的限制,提出了一种新型的跨视图地理定位网络(如图1),称为Swin-Radial-Locality Network (SRLN),有效提高了从不同视角获取的图像之间的匹配精度。在地理定位技术的发展过程中,实现精准高效的跨视角景象匹配一直是一个世界性挑战。无人机和卫星图像之间由于存在明显的视角差异,给地理定位带来了巨大困难,传统的图像检索方法往往难以准确捕捉这些视角之间的差异,导致定位性能不佳。为了突破这一瓶颈,团队经过大量深入研究,提出了一种新颖的SRLN框架,通过先进的图像处理技术,将多尺度特征融合和方向信息处理融入地理定位流程,从根本上增强了对不同视角图像特征的建模能力。该项创新性研究工作有力突破了传统地理定位方法的局限,为解决无人机和卫星图像的精确匹配问题贡献了全新的思路。

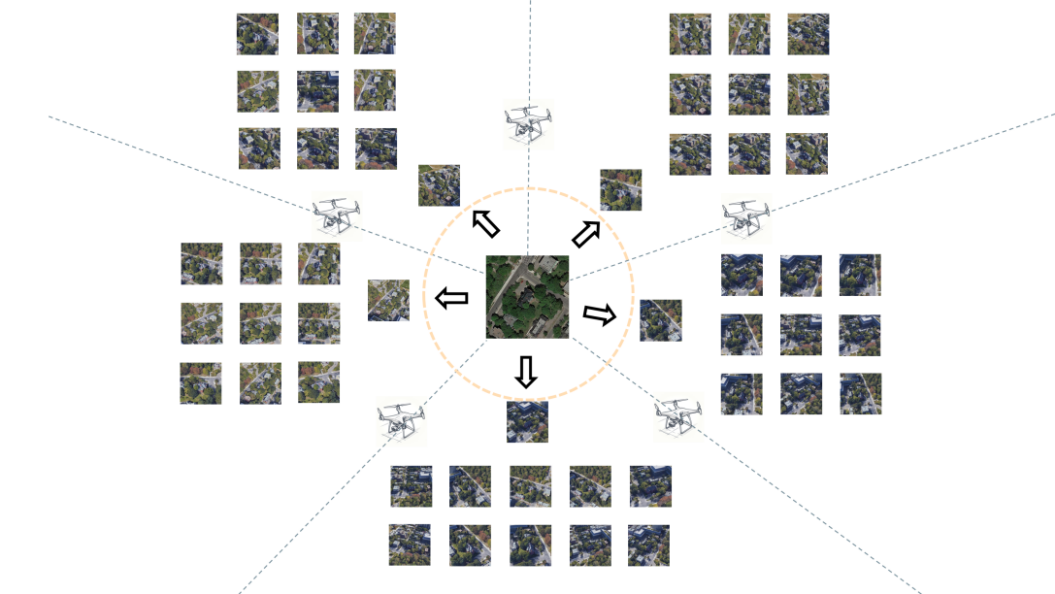

本论文中所使用的SUES-200数据集是电子电气工程学院“融合计算和位置服务”科研团队针对空地景象匹配的重要基础性成果,其目标是为了更好地帮助合理评价各类景象匹配算法优劣的情况,从而提出的一个开源标准测试benchmark。该研究前期研究成果已发表在知名期刊IEEE Transactions on Circuits and Systems for Video Technology上,是由团队的2021届硕士研究生朱润哲完成并发布,论文名称“SUES-200: A Multi-height Multi-scene Cross-view Image Matching Benchmark Across UAV and Satellite”,其数据是为跨视图图像匹配特别设计,涵盖了多种高度和场景的无人机与卫星视图,见图2。

图2 SUES-200数据集的数据跨视图图像采集与设计原理图

这项跨视图地理定位技术形成的SUES-200数据集对于视角差异导致的图像变形方面的处理表现出色,极大地提高了地理位置识别的准确性和效率,为遥感图像分析和地理信息系统的发展贡献了新的思路和方法,从而在城市规划、灾害监测和应急响应等领域具有广泛的应用潜力,展示了我校在地理信息系统领域的研究实力。目前,“融合计算和位置服务”科研团队以此为基础,已先后发表多篇高水平科研论文,获得全国大学生“挑战杯”国家一等奖,争取到上海市科委重大项目,并且被上海众多研究机构,以及武汉大学测绘重点实验室所关注和应用,团队希望今后能够进一步扩展开源数据集,形成泛化能力更强、测试针对性更高、数据代表性更丰富的系列“SUES-XXX”,能够在更多实际环境中得到应用和推广。